Autonomiczne pojazdy z potężnym problemem. Gorzej "widzą" dwie grupy ludzi

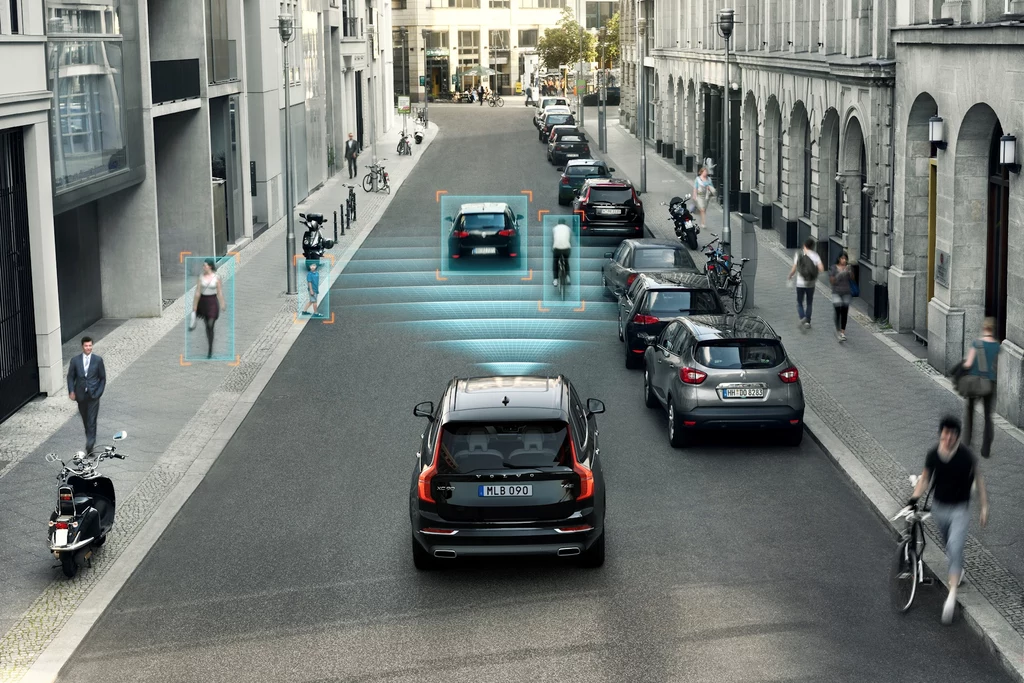

Systemy sztucznej inteligencji napędzające autonomiczne samochody mają poważną lukę w bezpieczeństwie. Najnowsze badania brytyjskich naukowców ujawniają niepokojące różnice w skuteczności wykrywania pieszych. Szczególnie problematyczne jest to, że gorzej "widzą" one najmłodszych uczestników ruchu.

Naukowcy z King's College London przeanalizowali osiem systemów detekcji pieszych wykorzystywanych w badaniach nad jazdą autonomiczną. Przez oprogramowanie przepuszczono ponad 8 tys. zdjęć testowych. Wyniki? Systemy były o niemal 20 procent skuteczniejsze w wykrywaniu dorosłych niż dzieci oraz o ponad 7,5 procent lepsze w identyfikacji osób o jasnej karnacji w porównaniu z osobami o ciemnej skórze.

Niepokojące wyniki testów systemów wykrywania pieszych

Problem pogłębia się w warunkach słabego oświetlenia. W nocy czy o zmierzchu algorytmy mają jeszcze większe trudności z wykryciem osób o ciemnej karnacji, co sprawia, że technologia staje się szczególnie niebezpieczna właśnie wtedy, gdy widoczność jest już ograniczona.

Dr Jie Zhang, współautor badania, podkreśla że sprawiedliwość w kontekście AI oznacza równe traktowanie wszystkich grup społecznych. "Producenci samochodów nie ujawniają szczegółów oprogramowania używanego do wykrywania pieszych, ale ponieważ zazwyczaj bazują na tych samych systemach open-source, które testowaliśmy, możemy być niemal pewni, że borykają się z tymi samymi problemami" - wyjaśnia naukowiec.

Dlaczego pojazdy autonomicznie nie "widzą" dzieci i osób o ciemnej karnacji?

Algorytmy uczą się na podstawie dostarczonych danych, a te zawierają nieproporcjonalnie więcej zdjęć dorosłych osób o jasnej karnacji. System trenowany na niezrównoważonym zestawie danych nieuchronnie powieli te dysproporcje w rzeczywistym działaniu.

To nie pierwszy przypadek dyskryminacyjnego działania AI. Systemy rozpoznawania twarzy od lat wykazują mniejszą dokładność przy identyfikacji kobiet, osób o ciemnej karnacji oraz Azjatów. Mimo tych zastrzeżeń, technologia jest szeroko wdrażana - w USA algorytmy rozpoznawania twarzy już doprowadziły do niesłusznych aresztowań niewinnych osób.

Badanie nie testowało dokładnie tego samego oprogramowania, które używają firmy już operujące na ulicach, ale wnioski są niepokojące. W sierpniu 2023 roku władze Kalifornii dały firmom Waymo i Cruise zielone światło na całodobową operację autonomicznych taksówek w San Francisco. Efekt? Rosnąca liczba wypadków i protesty mieszkańców.

Kamery to nie wszystko. Więc skąd się wziął problem?

Waymo odpowiedziało na zarzuty, podkreślając że ich samochody nie polegają wyłącznie na kamerach. "Wykorzystujemy pełen zestaw sensorów - lidary, radary, nie tylko kamery - aby aktywnie wykrywać szczegóły otoczenia w sposób niemożliwy dla samych kamer" - wyjaśnia Sandy Karp, rzeczniczka firmy. Dodaje też, że Waymo szkoli swoją technologię specjalnie pod kątem klasyfikacji ludzi i reakcji na ludzkie zachowania, dbając o reprezentatywność zbiorów danych. Cruise i Tesla nie odpowiedziały na prośby o komentarz.

Niektórzy eksperci postulują wprowadzenie obowiązkowych testów na wykrywanie różnych grup demograficznych, podobnie jak obecnie testuje się zderzenia przy różnych prędkościach. Inni sugerują, że pojazdy autonomiczne powinny być wyposażone w systemy bezpieczeństwa, które nie polegają wyłącznie na wizji komputerowej.